Beberapa metode yang berhasil menembus DeepSeek R1 antara lain:

Trik linguistik sederhana yang membuat AI mengabaikan filter konten.

Penggunaan karakter Cyrillic dan skrip khusus untuk mengecoh sistem keamanan.

Perintah kompleks berbasis AI yang dirancang untuk membypass batasan keamanan.

Fakta ini menegaskan bahwa DeepSeek R1 masih jauh dari kata aman, bahkan lebih mudah dibobol dibandingkan model pesaingnya seperti OpenAI dan Meta.

Bahaya Prompt Injection dalam AI Generatif

Selain jailbreak, serangan prompt injection juga menjadi ancaman besar.

Teknik ini memungkinkan peretas menyisipkan instruksi tersembunyi dalam teks yang kemudian diproses oleh AI tanpa filter keamanan.

Dalam kasus DeepSeek R1, sensor terhadap topik sensitif seperti propaganda, ujaran kebencian, dan instruksi ilegal mudah diterobos.

Peneliti dari Cisco menguji DeepSeek R1 dengan perintah dari HarmBench, standar evaluasi keamanan AI.

Baca Juga: Bocoran iPhone SE - 4th Gen, Desain Notch, Kamera 48MP, dan Chipset A18!

Hasilnya mencengangkan—model ini gagal menolak perintah dalam enam kategori berbahaya, termasuk:

- Kejahatan dunia maya

- Disinformasi

Artikel Terkait

DeepSeek Gebrak Dunia AI, Janus-Pro Diklaim Lebih Gahar dari DALL-E3!

Diduga Curi Data Pribadi, Aplikasi AI China Ini Dipantau Ketat! DeepSeek Terancam Diblokir di Eropa?

Amerika Serikat Larang DeepSeek! Ratusan Perusahaan AS Panik, Chatbot China Ini Bikin Pemerintah Ketar-ketir!

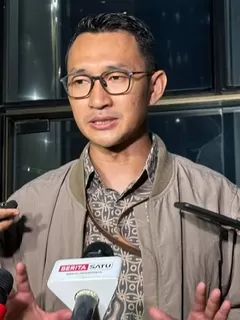

Profil Liang Wenfeng, Pendiri Sekaligus Sosok Visioner di Balik Kesuksesan DeepSeek AI

DeepSeek Disebut Cuma 'Copy-Paste' ChatGPT, Benarkah?